Kubernetes Data Platform 产品优势

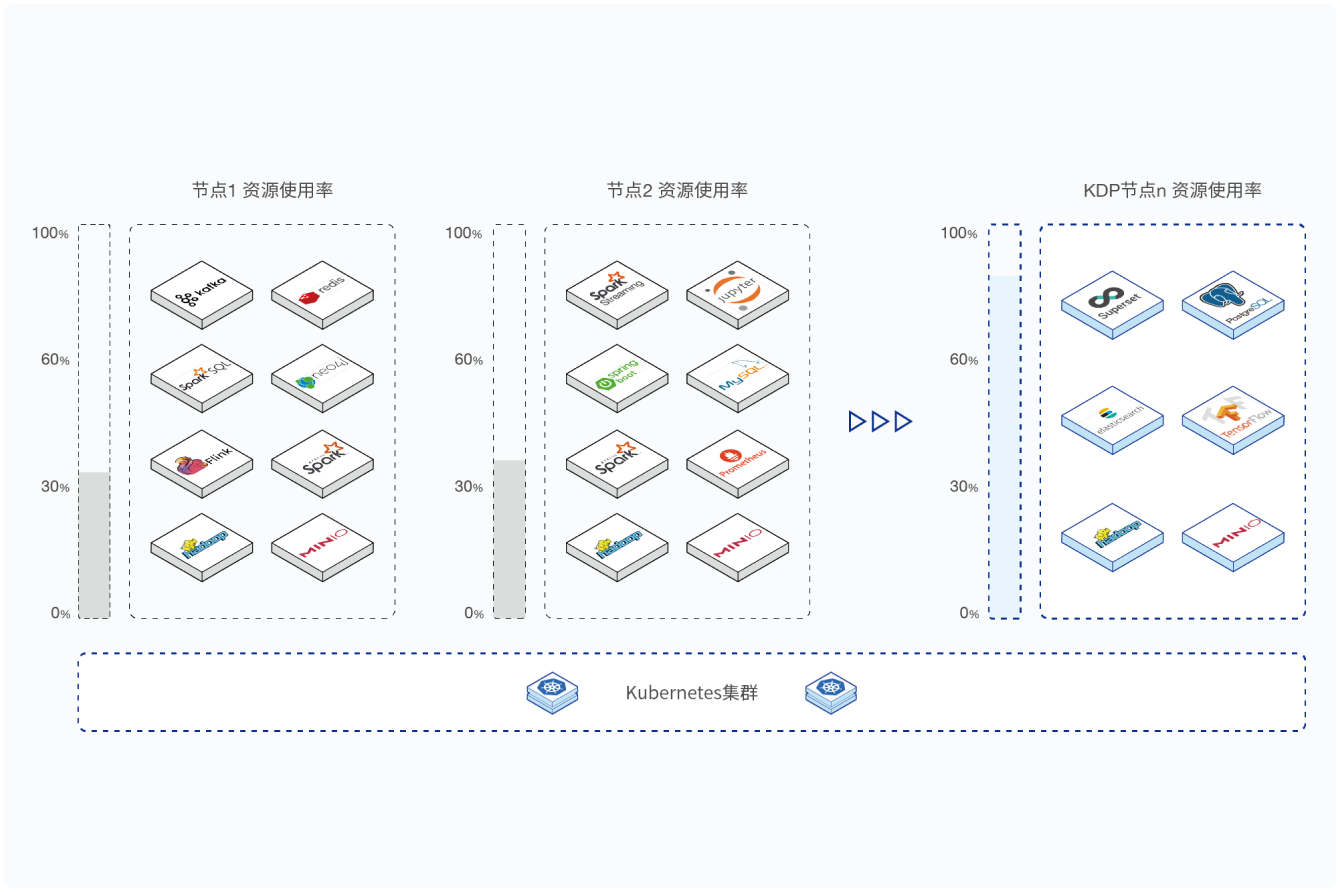

共享资源池与混合编排

集群资源作为一个可共享的资源池,实现实时/离线作业的混部,集群资源利用率相较于传统大数据平台的30%提升到60%

标准化配置管理

采用统一的Kubernetes文件配置方式,对大数据组件进行标准化的配置管理,简化大数据组件与Kubernetes集群的集成

自动化安装流程

通过标准化配置文件自动执行大数据组件到Kubernetes集群的步骤、更新、运维、升级等操作,降低大数据平台的部署复杂度

灵活调度策略

采用Volcano作为一级调度、Kubernetes作为二级调度进行调度机制的灵活、精细化管理,并实现大规模作业调度的低延时

弹性扩容

利用Kubernetes的弹性扩容技术,从容应对计算作业的性能瓶颈,实现计算资源及集群资源的动态扩容

标准化运维

基于Kubernetes标准的Operator操作方式,统一运维界面完成大数据组件的部署、升级、扩容、备份等操作,提升运维效率

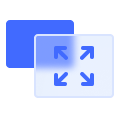

Kubernetes Data Platform 产品架构

Kubernetes Data Platform 产品功能概览

标准集成框架

提供标准集成流程,大数据组件以标准化配置文件的形式与统一系统服务对接,形成标准化部署、运行和运维流程。在K8s配置的基础上提供封装,简化大数据组件的配置流程,标准化组件、系统服务及其它组件的对接。

系统发布服务

提供从配置文件到K8s集群的发布、更新、运维、升级的完整服务,支持大数据类型的负载(如大量即起即停的批处理任务),可与大数据租户体系、权限管理、用户管理、资源管理的对接和集成。

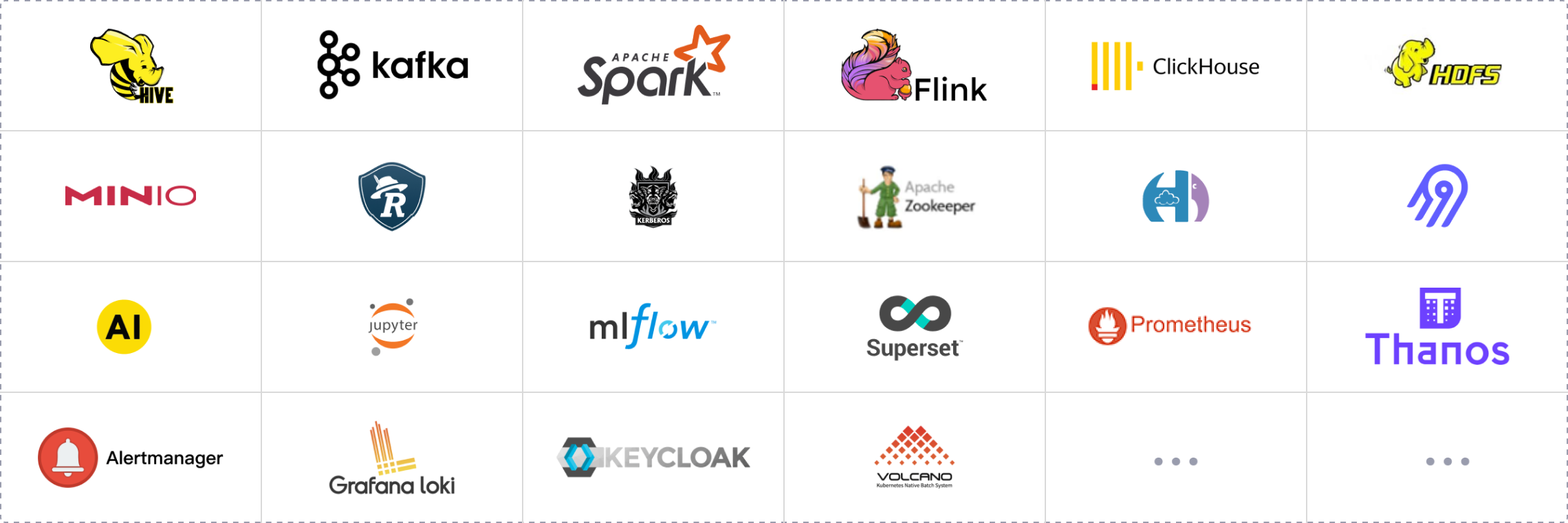

计算引擎云原生改造及集成

利用云原生的机制来提升如Hive、Spark、Flink、Kafka等计算引擎的组件性能,减少由于容器化和插件化带来的性能损耗,处理各种特性的大数据工作负载,并进行性能优化。

存储引擎云原生改造及集成

集成主流的大数据存储引擎如HDFS、MinIO及物理存储等,通过对开源代码的修改和扩展,强化了标准化的部署和运维、统一的可观测性服务、安全认证和鉴权机制等。

云原生的多租户和安全管理

提供多租户管理和资源隔离,创建单独的用户账号和对应的Kerberos keytab,并加入相应的安全组。每个安全组都有自己独立的K8s命名空间,每个命名空间都有对应资源配额。

可观测性服务

提供大数据组件及其执行的Workload日志,性能/稳定性的指标监控和报警,计费及审计功能。支持批处理任务,二级调度任务及各种数据层面的指标,实现全局指标观测、搜索与告警。

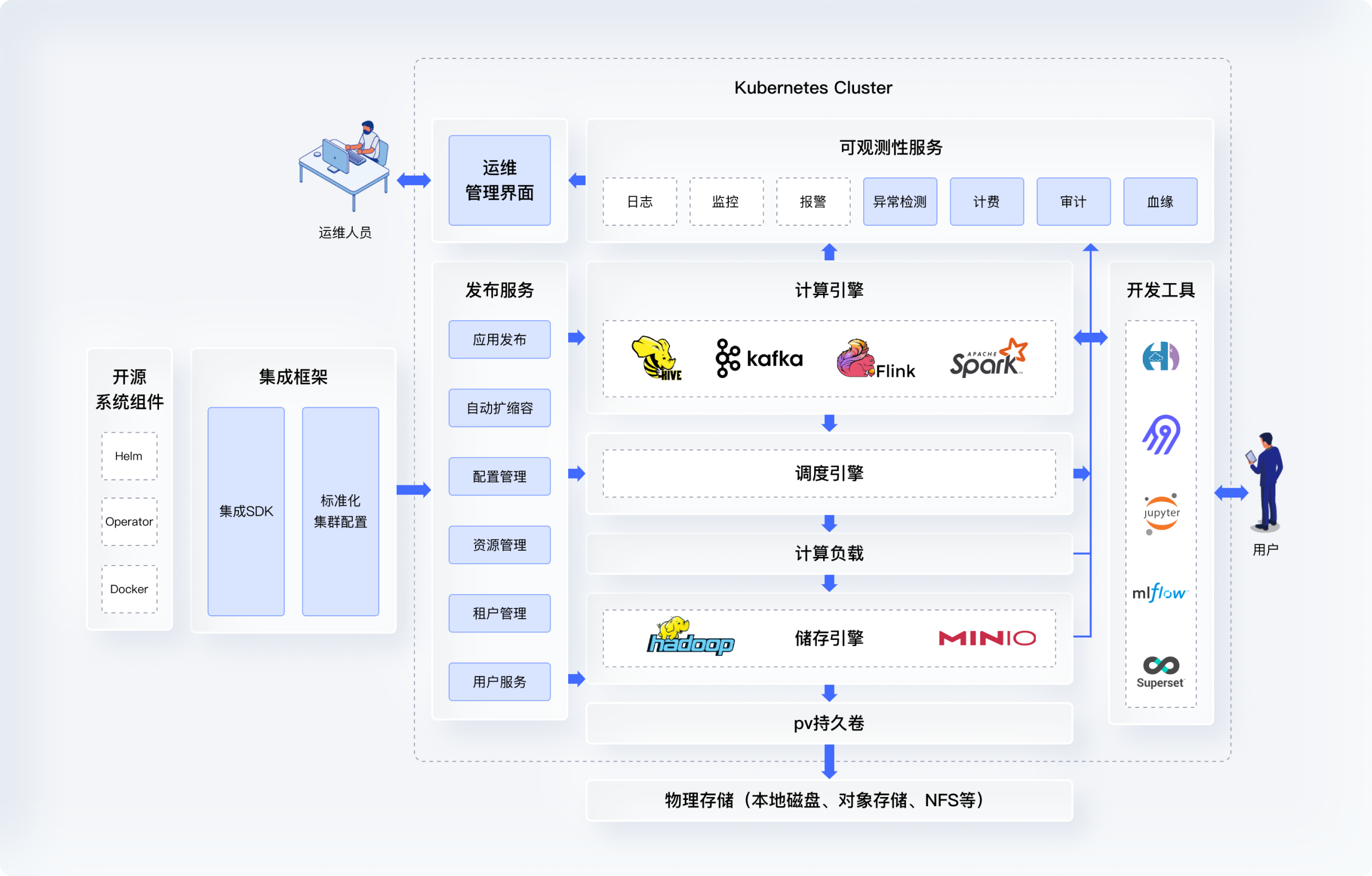

Kubernetes Data Platform 应用场景

助力企业在降本增效的同时,高效打造云原生数据能力平台,赋能数字化建设

- 高效的集群发布和运维

- 自助式的数字化创新

- 传统技术的升级改造

- 提升IT架构资源效率

高效的集群发布和运维

企业作为技术提供方要为多个内部或外部的机构进行大数据集群的部署和实施,但传统大数据平台的软件部署、组件互相适配、计算引擎调优等方案相对复杂,手工部署的步骤多,导致集群部署周期长,项目实施成本很高,运维流程复杂,运维人员能力要求高。

优势

采用KDP,可以大幅度提升实施项目的部署效率,降低项目实施运维人力和时间成本。

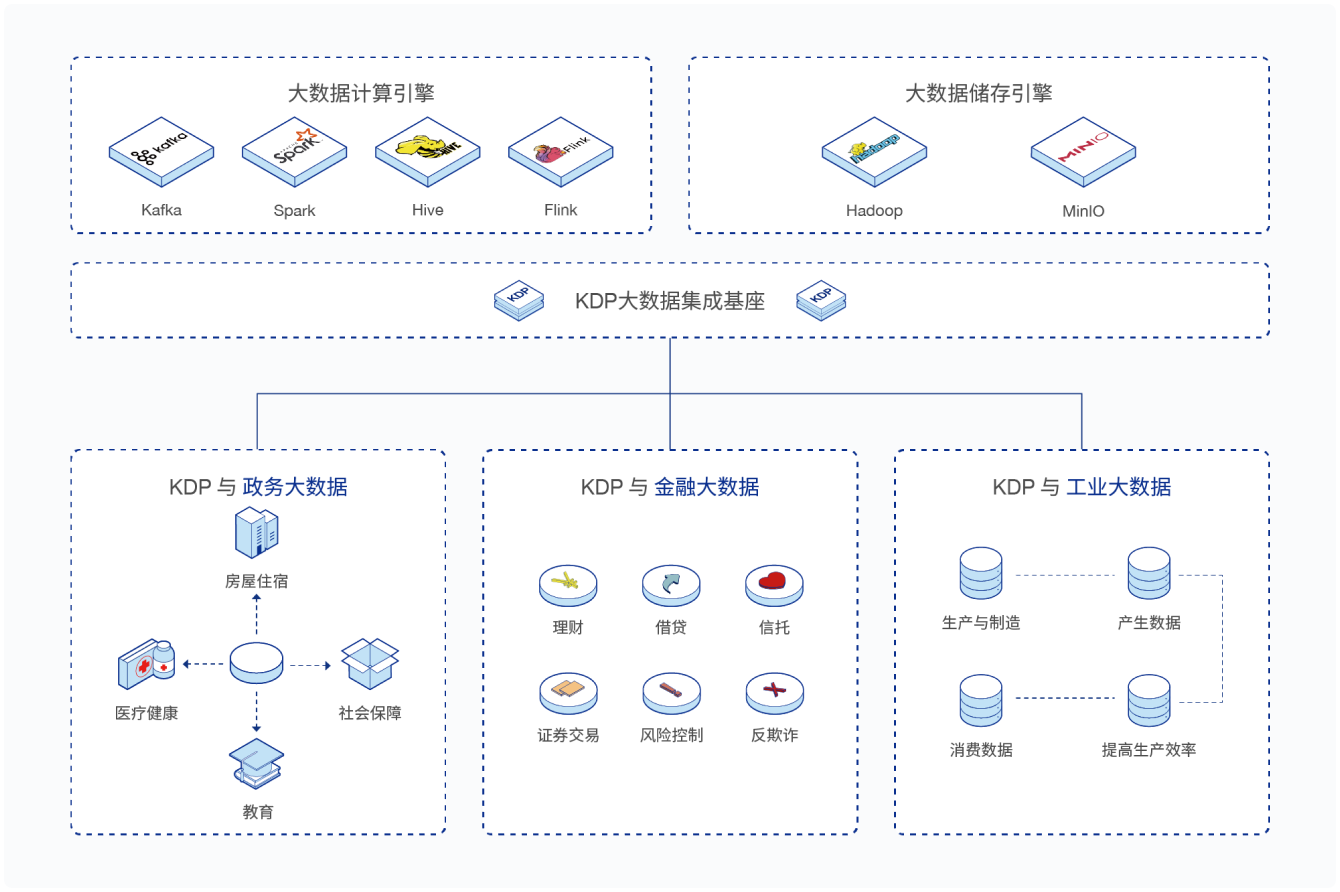

自助式的数字化创新

企业需要有多个大数据集群服务不同的业务部门,业务部门的数据科学家希望能自助式地尝试新的云原生人工智能机器学习工具。很显然,传统大数据平台满足不了这种自助式需要。

优势

企业可以通过KDP部署提升多平台管理效率,提供数据分析和人工智能开发工具的自助式发布,降低整体资源消耗的成本,加速数据价值的创造过程。

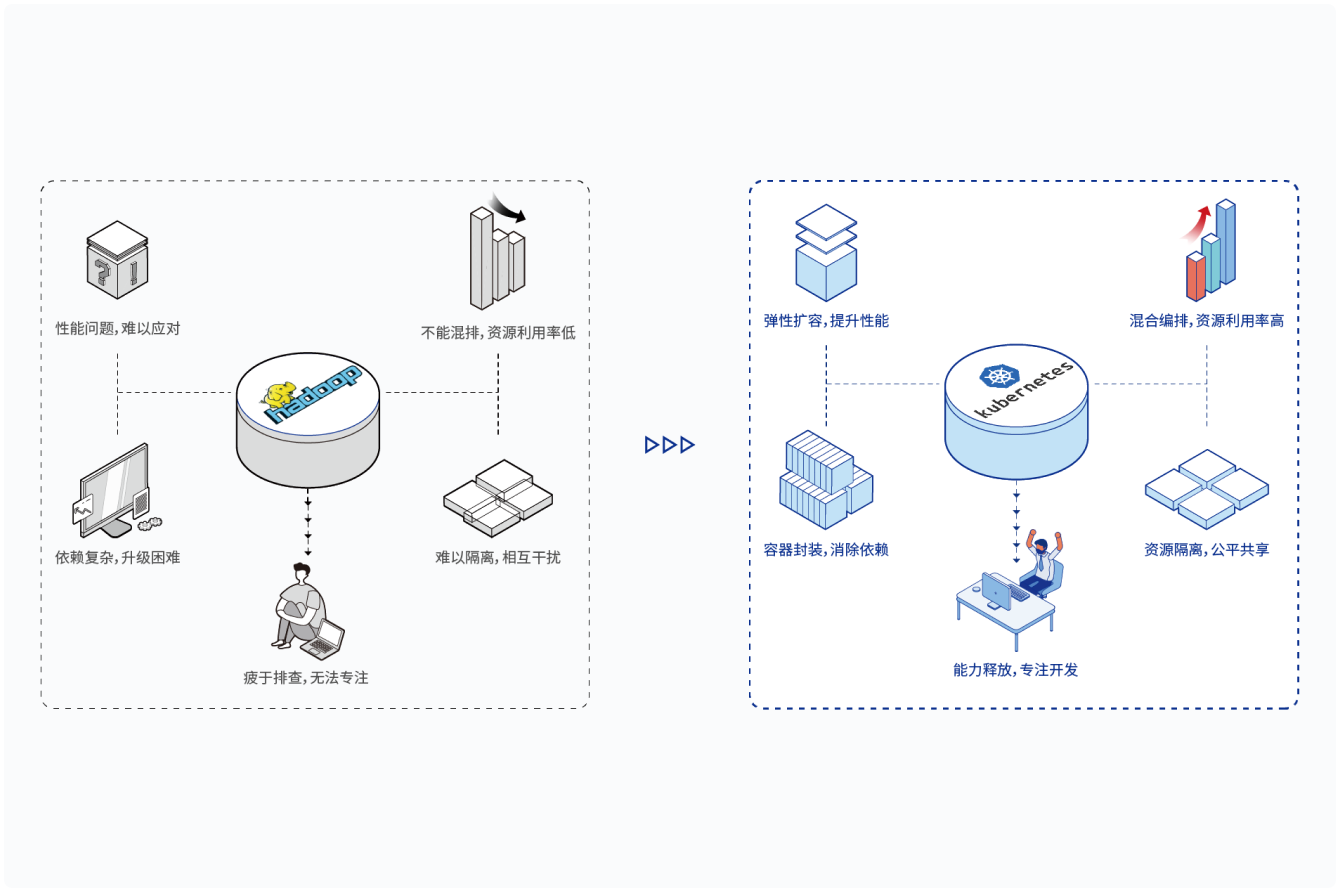

传统技术的升级改造

传统大数据平台因为技术扩展迭代流程比较慢,不能及时解决运维中碰到的性能瓶颈,大数据组件之间存在软件包依赖复杂、组件升级困难、新的组件集成耗时费力等问题。传统大数据平台的技术团队面对运维压力而难以专注于业务开发和数据价值的发现。

优势

迁移到KDP后,可以显著提升运维效率,降低运维成本,解放技术团队的生产力。

提升IT架构资源效率

企业在生产环境中会运行多种类型的数据应用、不同类型的存储引擎、实时和批处理的计算作业。在传统大数据平台环境下,一般都是采用独立的虚机集群来部署这样的生产环境,导致资源使用率很低。

优势

采用了KDP以后,企业可以利用作业混排、存算分离和精细化调度等平台特性来提升整体资源使用效率,降低IT架构的投入成本。

云原生集成

集成大数据组件、中间件、系统软件等,快速搭建高效可靠的分布式大数据系统

轻松玩转大数据

前100名提交信息即刻获与云原生大数据/数据中台专家一对一免费咨询机会,为您量身定制云原生大数据/数据中台建设方案